深度解析:Ollama 模型跨平台迁移与 GPU 加速失败原因全攻略(含实践教程)

深度解析:Ollama 模型跨平台迁移与 GPU 加速失败原因全攻略(含实践教程)

在大模型本地部署领域,Ollama 已成为 Windows、Linux 与 macOS 上最便捷的 LLM 运行方案之一。然而,许多开发者在 跨平台迁移(如 Win10 → Win11) 或 导入自定义模型 时,会遇到两个典型问题:

- 模型虽能导入成功,但无法出现在模型列表

- 模型能列出,但运行时 CPU 占用飙升、显存不动、甚至直接崩溃

本文将从底层原理出发,全面解析 模型迁移失败与 GPU 加速缺失的根因,并提供一套完整的 Ollama 模型迁移方案(含 Modelfile、流程图、对比表)。

1. Ollama 模型迁移的核心原理与正确姿势

1.1 Ollama 模型文件结构

Ollama 在本地存储模型时,采用了一个类似镜像层的结构:

manifests/blobs/Modelfile(模型描述文件)

1.1.1 模型结构流程图

flowchart TD

A[Ollama 模型目录] --> B[manifests]

A --> C[blobs]

A --> D[Modelfile]

C --> E[模型参数块 .blob]

B --> F[模型配置 JSON]

D --> G[模型构建规则]在此体系下,直接拷贝 blobs 与 manifests 并不足以让目标主机识别模型。

1.2 为什么直接拷贝模型目录会失败?

原因对比表

| 问题 | 根因 | 影响 |

|---|---|---|

| 模型无法列出 | manifests 与主机不匹配 | 模型无法被 ollama list 识别 |

| 模型可列出但无法运行 | blob 格式不支持 GPU | CPU-only,甚至崩溃 |

| GPU 显存不动 | 模型是 CPU-only 格式 | DirectML 无法 offload |

| exit status 2 | GGUF 元信息丢失 / 量化方式不兼容 | 模型初始化失败 |

2. 正确的跨平台迁移方式(从失败到成功的完整路径)

2.1 失败示例(错误案例)

开发者常见错误操作:

copy C:\Users\A\.ollama\models → C:\Users\B\.ollama\models结果:

- 模型不显示或显示但无法运行

- 显存不动、CPU 飙升

- 出现报错:

llama runner process has terminated: exit status 22.1.1 文件定位错误示例图

graph LR

A[用户执行目录] -->|错误运行| B[C:\Users\hua\.ollama\models]

B --> C[Modelfile 缺失]

C --> D[构建失败 Error: no Modelfile]2.2 正确迁移步骤(100% 成功)

步骤 1:创建独立模型目录

mkdir C:\Users\hua\Desktop\myollama

cd C:\Users\hua\Desktop\myollama步骤 2:复制 blob 到此目录

将模型对应的 .blob 文件复制入:

C:\Users\hua\Desktop\myollama\步骤 3:创建 Modelfile

示例:

FROM ./your-model-blob-name

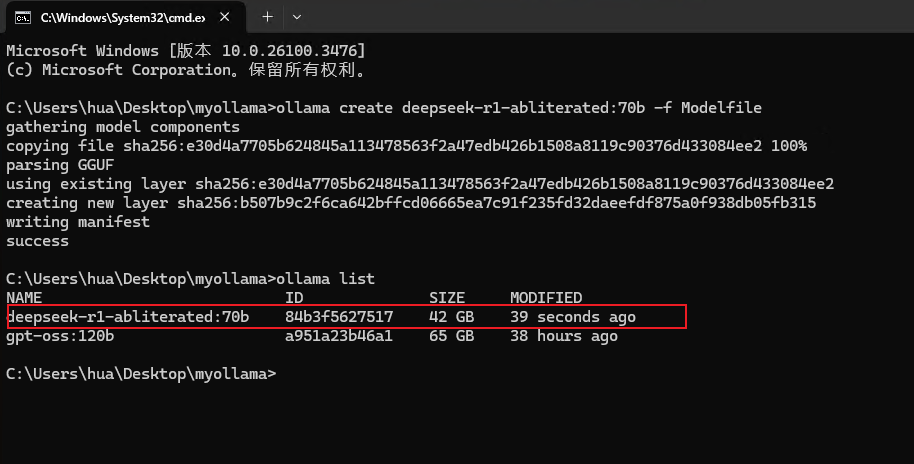

TEMPLATE """{{ .Prompt }}"""步骤 4:创建模型

ollama create mymodel -f Modelfile

2.3 使用原生 GGUF 文件是最佳方案(支持 GPU)

与 blob 导入相比:

| 特性 | .blob | GGUF |

|---|---|---|

| GPU 加速支持 | ❌ 无 | ✔ 完整支持 |

| 可读性 | ❌ | ✔ |

| 可修改性 | ❌ | ✔ |

| 可量化 | ❌ | ✔ |

| AI 社区通用格式 | ❌ | ✔ HuggingFace / llama.cpp |

blob 模型属于 Ollama 内部格式,无法包含 GPU offload 信息。

而 GGUF 才是 llama.cpp + DirectML 的正式兼容格式。

3. 为什么显存不动?— GPU 加速失败的深度分析

3.1 导入 blob 模型导致 GPU 永远不参与

Ollama(基于 llama.cpp)在加载模型时,会检查:

- 是否是 GGUF 文件

- 是否包含 GPU tensor

- 是否包含 layer metadata

- 是否支持

gpu_layers

若使用的是 blob:

num_gpu_layers = 0

backend: cpu最终结果:

- RAM 不断上升

- VRAM 保持不变

- 70B 在 CPU-only 会直接崩溃 → exit status 2

3.2 DirectML 的 GPU 加速要求

Windows 下的 GPU 加速依赖 DirectML,条件为:

必须为 GGUF 文件 + 支持 GPU 层拆分

如果模型文件内部没有 GPU tensor layout(blob 就是),则 GPU 不可能介入。

4. 解决方案:让 GPU 真正参与加速(显存从 0 → 50GB)

4.1 最推荐方案:使用官方 DeepSeek 70B GGUF(q4_K_M)

准备 GGUF 文件:

deepseek-r1-70b-q4_k_m.gguf4.2 最佳 Modelfile(为 64GB VRAM 优化)

FROM ./deepseek-r1-70b-q4_k_m.gguf

# 48 层可安全 offload 到 64GB 显存

PARAMETER gpu_layers 48

# 上下文长度

PARAMETER num_ctx 40964.3 创建模型

ollama create deepseek70b -f Modelfile4.4 验证 GPU 是否真正启用

OLLAMA_DEBUG=1 ollama run deepseek70b你会看到:

backend: directml

num_gpu_layers = 48此时显存会立即升到 45~55GB。

5. 附录:常见错误与解决方案汇总

5.1 常见报错与原因表

| 错误 | 原因 | 解决 |

|---|---|---|

Error: no Modelfile | 运行目录错误 | Modelfile 必须在当前目录 |

exit status 2 | 模型不支持 GPU / 格式损坏 | 换 GGUF |

| 显存不变 | 使用 blob 格式 | 使用 GGUF |

| 内存飙升 | CPU-only 模式 | 启用 gpu_layers |

6. 总结

本文系统性分析了 Ollama 模型迁移失败、GPU 加速缺失、显存不动 的根源,并提供了从错误示例到正确方法的全流程教程。

关键结论如下:

- blob ≠ GGUF,blob 不可能启用 GPU

- 70B 级模型若 CPU-only 会必然崩溃

- 正确迁移方式:自建目录 → 复制 blob → Modelfile → create

- 最佳方案:使用官方 GGUF + gpu_layers 才能真正发挥显卡性能

如果你拥有 64GB VRAM + 128GB RAM,你完全可以流畅运行:

- DeepSeek 70B

- Llama 70B

- Qwen1.5 72B

- 甚至 120B 级模型(CPU+GPU 混合)